-1.png?width=150&height=150&name=%E5%A4%A7%E8%A6%8F%E6%A8%A1AI%E5%AD%A6%E7%BF%92%E5%90%91%E3%81%91(H200)-1.png)

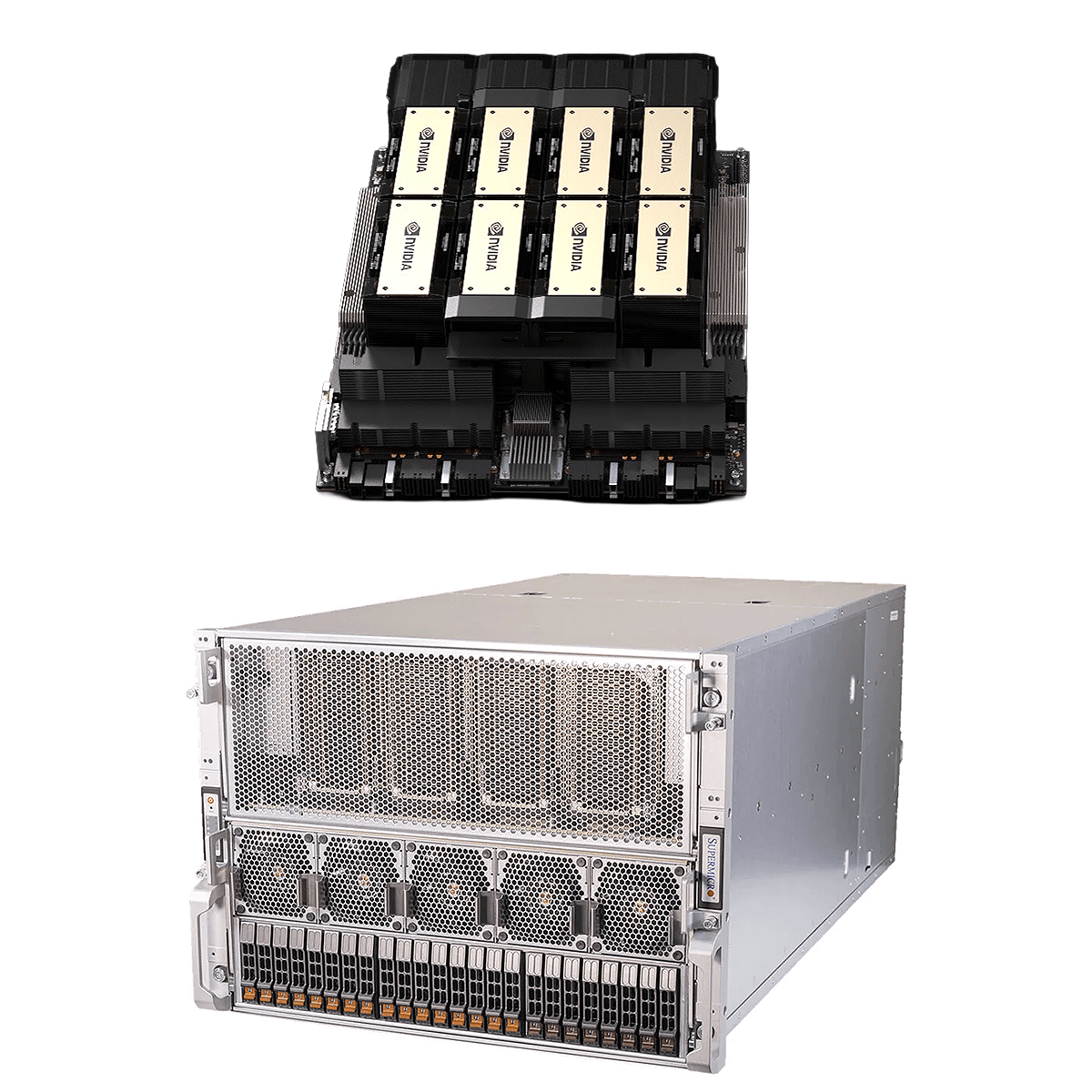

・生成AI・LLMなど、大規模モデルの学習に最適

・大容量メモリで重負荷ワークロードに対応

・FP8/FP16演算で計算効率最適化

-1.png?width=167&height=150&name=AdobeStock_1776034633%20(1)-1.png)

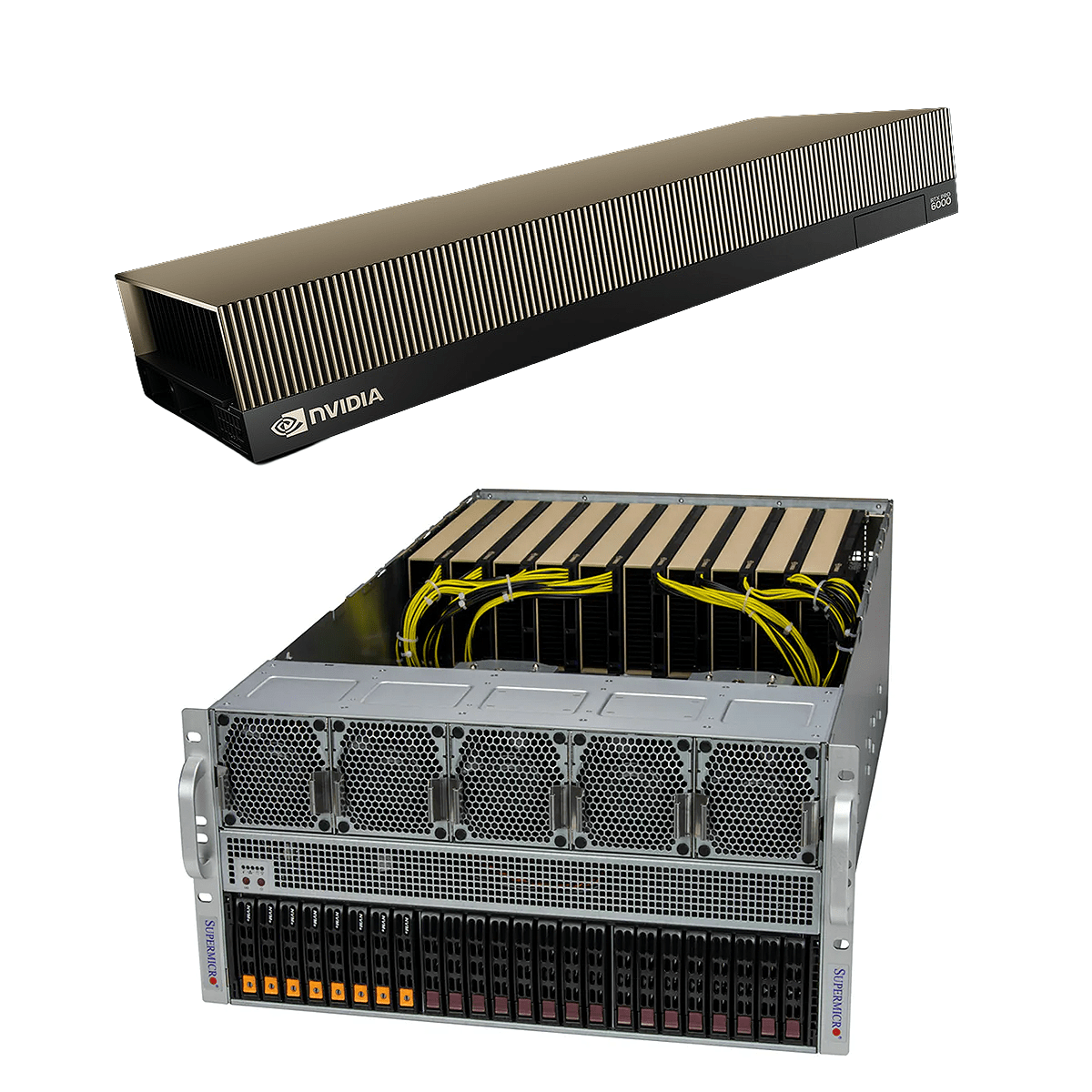

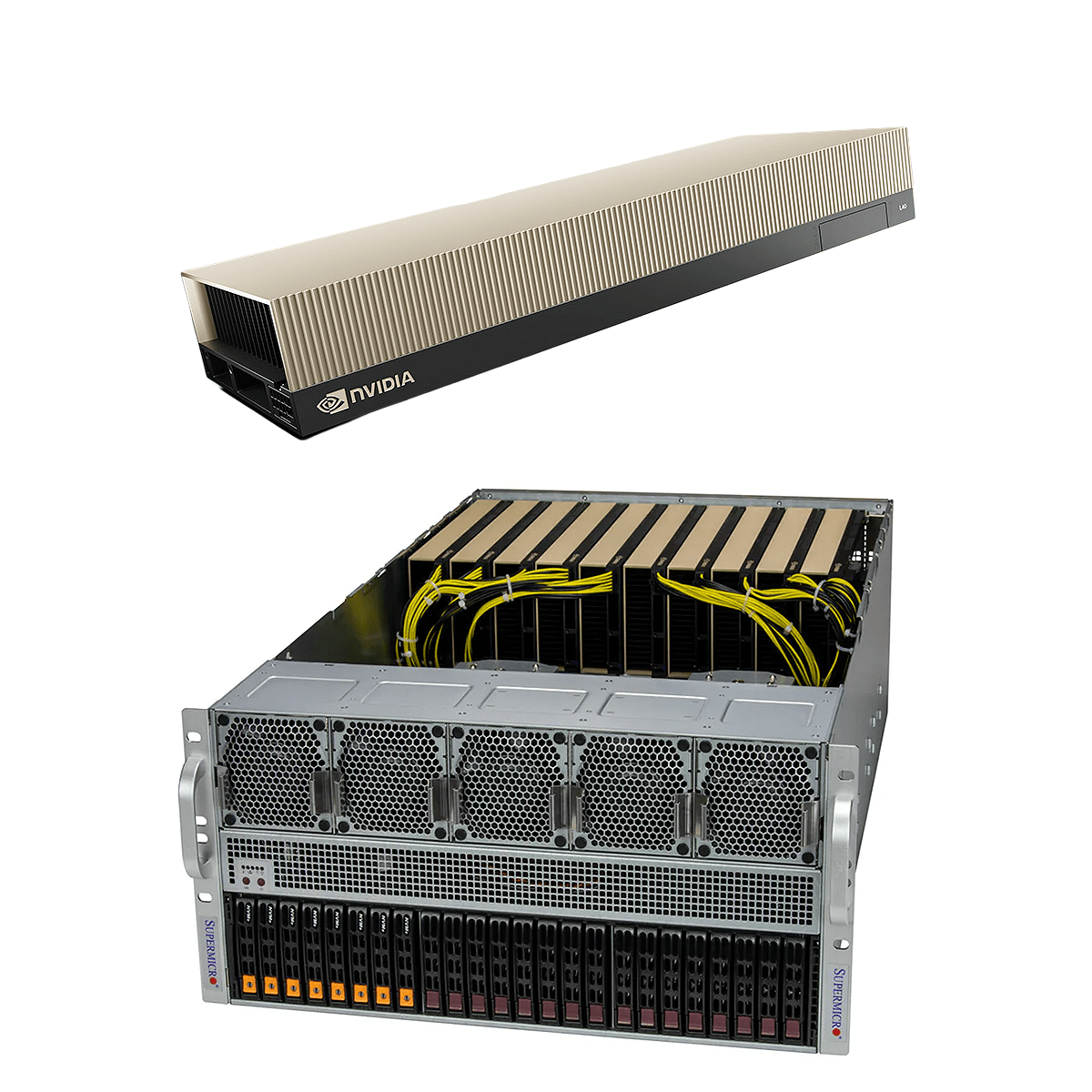

・学習済みモデルの高速推論に応対可能

・分析処理、画像生成など多様なモデルに対応

・安定稼働で継続的に運用に最適

.png?width=280&height=60&name=%E3%81%8A%E5%95%8F%E3%81%84%E5%90%88%E3%82%8F%E3%81%9B%E3%83%9C%E3%82%BF%E3%83%B3(%E8%A7%92%E4%B8%B8).png)

.png?width=280&height=60&name=%E3%81%8A%E5%95%8F%E3%81%84%E5%90%88%E3%82%8F%E3%81%9B%E3%83%9C%E3%82%BF%E3%83%B3(%E8%A7%92%E4%B8%B8).png)

| キャンペーン申込期間 | 2025年12月1日 ~ 2026年3月31日 |

| 対象製品 |

・NVIDIA H200 SXM 搭載パッケージ |

| 目安納期 | ご注文から約2~3か月 ※需要次第ではこれ以上のお時間を要する場合がございます。 |

| 適用条件 |

|

NVIDIA GPU搭載サーバーの設計・導入は

AIインフラのプロフェッショナル トゥモロー・ネットにお問い合わせください。