運用・セキュリティ・拡張までを見据えた

マルチAIエージェント搭載アプライアンス

Qeek AI Orchestrator

Qeek AI Orchestrator は、社内データを外に出さず、業務で使われるAIエージェントを実行する基盤です。

AIを導入しても、業務のどこかで人の手に戻ってしまう。

それは、AIが業務の「一部」しか担えていないからです。

情報を探す、判断する、処理する、次のアクションへつなぐといった、複数の処理をまとめて実行できる基盤が必要です。

多くの業務は、単一の作業では完結しません。

情報を探し、判断し、処理し、次のアクションへつなぐ。

AIがその一部だけを担っても、業務全体は自動化されず、活用は定着しません。

業務の流れは、ひとつのAIでは完結しません。

情報を収集するAI、

判断を行うAI、

処理を実行するAI。

それぞれの役割を持つAIが連携し、一連のタスクとして業務を進める。

それが、マルチAIエージェントの考え方です。

CAT.AI マルチAIエージェントサイト

https://cat-ai.jp/multi-aiagent/

単一のAIでは、業務の“次の工程”を引き継ぐことができません。

マルチAIエージェントは、業務を止めずに次へつなぐための仕組みです。

たとえば、

問い合わせ内容を理解する

必要な情報を検索する

判断・処理を行う

結果を次の業務へ渡す

こうした工程を、複数のAIが分担しながら自動で進めていきます。

ただし、こうしたマルチAIエージェントを業務で安定して動かし続けるには、もうひとつ重要な要素があります。

問い合わせ内容を理解し、必要な情報を照会、判断し、処理を実行。

複数の手続きを一連の流れとしてつなぎ、業務を止めずに完結させます。

規程やルールを参照しながら判断し、必要な処理や申請業務を支援。

業務の属人化を防ぎ、安定した運用を実現します。

たとえば、顧客情報の照会や各種手続き、状況に応じた更新処理など、複数の業務が連なって発生するケース。

それぞれの処理をつなぎながら、業務全体を一連の流れとして支援します。

マルチAIエージェントを業務で使い続けるには、モデルの性能だけでなく、運用・セキュリティ・拡張までを含めた全体設計が欠かせません。

業務ごとに異なるAI構成や処理フロー、扱うデータの性質に応じて、安定した実行環境が求められます。

Qeek AI Orchestratorは、こうした要件を前提に、選定されたGPUサーバー上でマルチAIエージェントを実行するために構成されたアプライアンスです。

単一のAIを動かすための環境ではなく、複数のAIが役割分担しながら連携することを前提に構成。

業務の流れを止めない実行基盤を提供します。

業務で使い続けるために必要な、運用管理やセキュリティを考慮した構成。

導入後の運用まで見据えたアプライアンスです。

業務内容や課題に応じて、AI構成や処理フローを個別に設計。

画一的ではない、業務にフィットした活用を支援します。

Qeek AI Orchestratorで、業務に“使われ続けるAI”を検討しませんか?

業務内容や課題に合わせた活用イメージや、構成の考え方をご紹介します。

まずはお気軽にご相談ください。

Qeek AI Orchestratorの設計・導入は

AIインフラのプロフェッショナル トゥモロー・ネットにお問い合わせください。

| 仕様 | 数量 | 補足 | |

| System | 1U rackmount | 1 | |

| CPU | Intel Xeon 4510 12Core 2.4Ghz | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 4 | |

| Storage | 2.5“ SSD SATA 960GB (OS領域) | 2 | ハードウェア RAID 1 |

| 2.5“ SSD SATA 7.68TB (データ領域) | 4 | ハードウェア RAID 10 | |

| NIC | 2port Intel X710-AT2 10GbE RJ45 | 1 | |

| Power Supply | 860W Redundant Titanium Level Hot-plug power supplies | 1 |

| 仕様 | 数量 | 補足 | |

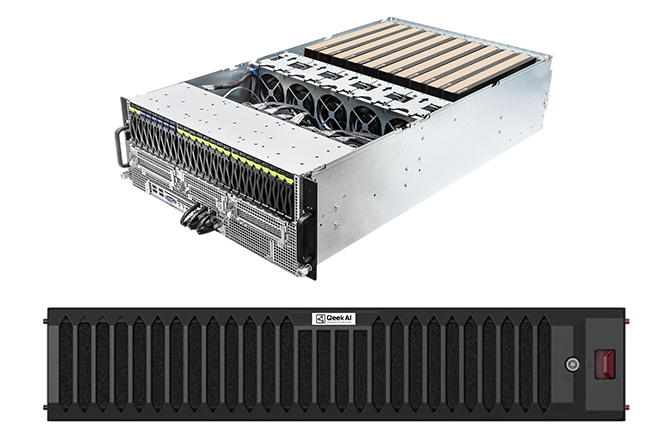

| System | 4U rackmount | 1 | |

| CPU | Intel Xeon 6530P 32Core (2.3/2.8GHz) | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 16 | |

| Storage | 2.5“ PM893 SATA SSD 960GB (OS領域) | 2 | ハードウェア RAID 1 |

| 2.5“ SSD SATA 7.68TB (データ領域) | 4 | ハードウェア RAID 10 | |

| NIC | 4port Intel XL710+ X557 10GbE / RJ45 AOC | 1 | |

| 2port Intel i350 1GbE / RJ45 onboard | 1 | ||

| GPU | NVIDIA RTX PRO 6000 Server Edition 96GB | 2 | |

| Power Supply | 3+1, 80-PLUS Titanium, 3200W | 1 |

| 仕様 | 数量 | 補足 | |

| System | 2U rackmount | 1 | |

| 1ノードあたりの仕様 (4ノード マルチノードアーキテクチャ) | |||

| CPU | Intel Xeon 6530 32Core 2.1GHz | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 8 | |

| Storage | M.2“ NVMe 960GB (OS 領域) | 2 | ハードウェア RAID 1 |

| 2.5“ U.2 NVMe 7.68TB (データ領域) | 6 | Ceph OSD | |

| NIC | 4port Intel E810-CAM1 25GbE / SFP28 AIOM | 1 | |

| 4port Inte XL710-BM1 10GbE / RJ45 AOC | 1 | ||

| Power Supply | 3000W Redundant Titanium Level power supplies | 1 |

| 仕様 | 数量 | 補足 | |

| System | 4U rackmount | 1 | |

| CPU | Intel Xeon 6530P 32Core (2.3/2.8GHz) | 2 | |

| Memory | DDR5-5600 ECC REG DIMM 64GB | 16 | |

| Storage | 2.5“ PM893 SATA SSD 960GB (OS領域) | 2 | ハードウェア RAID 1 |

| NIC | 4port Intel E810-CAM1 25GbE / SFP28 AOC | 1 | |

| 4port Intel XL710+ X557 10GbE / RJ45 AOC | 1 | ||

| 2port Intel i350 1GbE / RJ45 onboard | 1 | ||

| GPU | NVIDIA H200NVL 141GB | 8 | |

| GPU Option | NVLINK Bridge Board Hopper GPU 4way Passive | 2 | |

| Power Supply | 3+1, 80-PLUS Titanium, 3200W | 1 |

Qeek AI Orchestratorの設計・導入は

AIインフラのプロフェッショナル トゥモロー・ネットにお問い合わせください。

A. スターターモデル以外は完全オフラインでの利用を想定しており、インターネット接続を必要とせずLANのみでAIを利用可能です。

スターターモデルについてはGPUを内蔵しないアプライアンスのため、外部のAI(ChatGPTなど)と連携して動作しますのでインターネット接続が必要です。

A. スターターモデルはGPUを搭載しないことにより安価で導入可能なモデルです。

スタンダードモデルは内部にGPUを搭載し、インターネットに接続せず機微な情報もAIで利活用することができるモデルです。

スケールモデルはGPUモデルの特長に加えて高性能なGPUを搭載し、GPUサーバーを追加(スケールアウト)することでさらに大規模な利用にも対応するモデルです。

A. すべてラックマウント型のサーバーで構成されているため、設置にはサーバーラックが必要です。そのため社内のサーバールームや、ハウジングデータセンターへの設置が必要となります。

A. スターターモデル、スタンダードモデルについては特別なネットワークスイッチが必要ないため、既存のネットワークスイッチに接続すれば利用可能です。もし追加で必要であれば当社からご案内することも可能です。

スケールモデルは高速なネットワークが必要になるため、基本的に当社からご案内いたします。